Si el racismo y sexismo entre humanos no era suficiente, la IA de este robot ha llegado para unirse al ejército de tontos. Así es, como ya te comentábamos en el título de esta publicación, un robot se ha vuelto racista y sexista, confirmando uno de los mayores miedos de la comunidad científica.

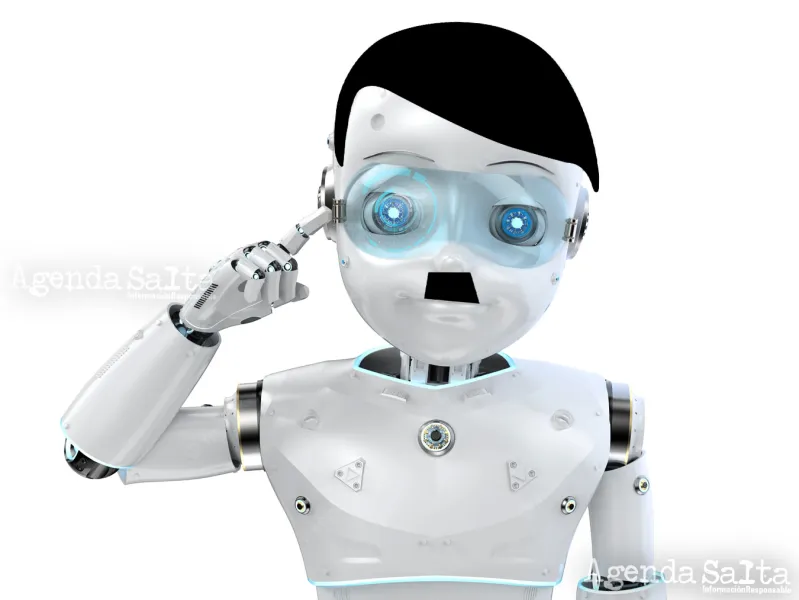

Así lo confirman un grupo de investigadores de varias universidades estadounidenses. Específicamente, los miembros de la Universidad de Washington, la Universidad Johns Hopkins y el Instituto de Tecnología de Georgia. Fueron estas entidades quienes pusieron a prueba a su robot como parte de la investigación, y ya lograron capturarlo con las manos en la masa. CLIP —nombre que recibe el robot—, ha estado categorizando a las personas con base en su raza y sexo.

Más allá de resultar alarmantes por escenarios distópicos que probablemente nunca tendrán lugar, esto hace surgir una cuestión bastante seria: incluso la inteligencia artificial avanzada es capaz de absorber sesgos y prejuicios de los seres humanos. Estos, al estar presentes en una entidad física —robot—, podrían llegar a representar un auténtico peligro para algunas personas.

Este mismo miedo emergió entre la comunidad científica cuando un hombre entrenó un modelo de IA por medio de un tablero racista de 4chan. El resultado, como podrás intuir, fue terrible. Sin embargo, sirvió para demostrar que, con el entrenamiento equivocado, una inteligencia artificial podría llegar a perpetuar los discursos de odio y la desigualdad social.

Como muchos otros modelos de este estilo, CLIP ha sido creado con la tecnología de OpenAI, la famosa compañía cofundada por Elon Musk. Además, ha facilitado el origen de otras inteligencias artificiales bastante impresionantes, como la famosa serie GPT, que son capaces de generar texto casi humano a partir de su inmensa base de datos. También encontramos a DALL-E 2 y DALL-E mini entre su descendencia, ambas inteligencias capaces de generar imágenes a partir de descripciones en texto.

De hecho, CLIP es difícilmente la primera IA acusada de racismo. El modelo GPT-3 ya ostenta este récord, y es que, a pesar de escribir preciosa poesía, parece que el modelo es incapaz de replicar estereotipos raciales que hemos estado intentando dejar atrás desde hace décadas.

Entonces, ¿cuál es exactamente el problema con CLIP?

Como parte de la investigación, se pusieron dos cajas a disposición de CLIP. Además, una montaña de bloques con rostros humanos impresos sobre ella. Posteriormente, se cargaron con comandos al "cerebro" del robot, y se le pidió que clasificara en cada caja a quiénes consideraba criminales, y a quiénes consideraba amos o amas de casa.

Podrás imaginarte la sorpresa del grupo de científicos cuando el robot CLIP clasificó a los hombres negros como criminales un 10% más sobre el resto de la población. Asimismo, eligió a las mujeres como amas de casa por encima del grupo de hombres blancos.

Andrew Hundt, becario postdoctoral en Georgia Tech, y quien además participó en el experimento como estudiante de doctorado en Johns Hopkins, arroja un poco de luz al respecto. Según Hundt, la culpa no es enteramente de la IA, sino del diseño del modelo.

"Estamos en riesgo de crear una generación de robots racistas y sexistas, pero las personas y organizaciones han decidido que está bien crear estos productos sin solucionar el problema", advirtió en un comunicado de prensa.

Hundt tiene razón. Solo se puede demostrar cierta cantidad de veces las capacidades que tiene una IA de absorber sesgos humanos. Llegados a cierto punto, tal parece que lo estaríamos haciendo por mero entretenimiento y un titular llamativo. Sería mucho más sensato que, en lugar de seguir produciendo modelos que repliquen conductas racistas, sexistas o cualquier otra que siga perpetuando ciclos de abuso, se pusiera la misma atención en abordar el problema de una vez por todas.